- Автор Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Последнее изменение 2025-01-22 17:38.

С точки зрения непрофессионала, себя - внимание механизм позволяет входам взаимодействовать друг с другом (« себя ») И узнайте, кому они должны платить больше внимание к ( внимание »). Выходы находятся совокупности этих взаимодействий и внимание оценки.

Кроме того, что такое внимание к себе?

Себя - внимание , иногда называемый внутри- внимание является внимание механизм, связывающий различные позиции одной последовательности, чтобы вычислить представление последовательности.

Кроме того, что такое самовнимание в глубоком обучении? Сначала давайте определим, что " себя - Внимание " является. Ченг и др. В своей статье под названием «Сети с долгосрочной краткосрочной памятью для Машина Чтение », определил себя - Внимание как механизм соотнесения различных позиций одной последовательности или предложения, чтобы получить более яркое представление.

В связи с этим, что такое механизм внимания?

Механизм внимания позволяет декодеру обращаться к различным частям исходного предложения на каждом этапе генерации вывода. Вместо того, чтобы кодировать входную последовательность в один фиксированный вектор контекста, мы позволяем модели научиться генерировать вектор контекста для каждого временного шага вывода.

Что такое модель на основе внимания?

Внимание - основанные модели принадлежат к классу модели обычно называется от последовательности к последовательности модели . Цель этих модели , как следует из названия, он производит выходную последовательность для входной последовательности, которая, как правило, имеет разную длину.

Рекомендуемые:

Как работает прокси Spring AOP?

Прокси-сервер АОП: объект, созданный фреймворком АОП для реализации контрактов аспектов (советовать выполнение методов и т. Д.). В Spring Framework прокси AOP будет динамическим прокси JDK или прокси CGLIB. Плетение: связывание аспектов с другими типами приложений или объектами для создания рекомендованного объекта

Как работает зеркальный телевизор?

Зеркальный телевизор состоит из специального полупрозрачного зеркального стекла с ЖК-телевизором за зеркальной поверхностью. Зеркало тщательно поляризовано, чтобы изображение могло проходить через зеркало, так что когда телевизор выключен, устройство выглядит как зеркало

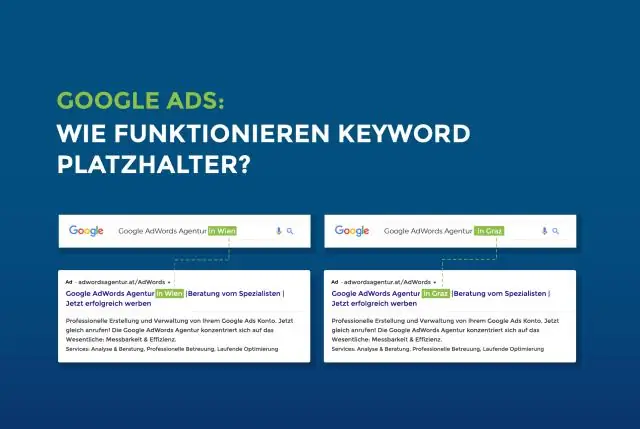

Как работает заполнитель?

Атрибут placeholder указывает короткую подсказку, которая описывает ожидаемое значение поля ввода (например, примерное значение или краткое описание ожидаемого формата). Примечание. Атрибут placeholder работает со следующими типами ввода: текст, поиск, URL-адрес, тел., Электронная почта и пароль

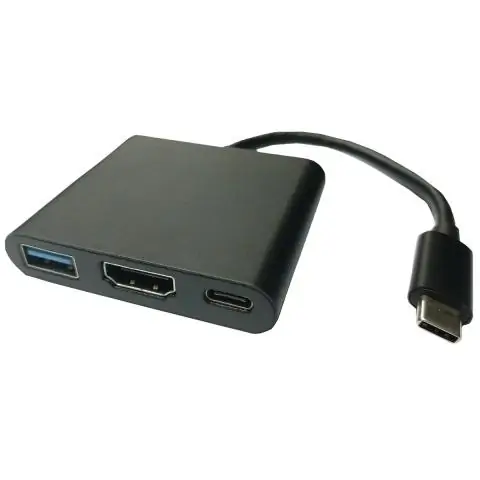

Как работает USB-адаптер дисплея?

Видеоадаптеры USB - это устройства, которые используют один порт USB и подключаются к одному или нескольким видеосоединениям, таким как VGA, DVI, HDMI или DisplayPort. Это полезно, если вы хотите добавить дополнительный дисплей в настройки вашего компьютера, но на вашем компьютере нет видеосоединений

Как работает SQL, кроме как?

SQL - EXCEPT Clause. Предложение / оператор SQL EXCEPT используется для объединения двух операторов SELECT и возвращает строки из первого оператора SELECT, которые не возвращаются вторым оператором SELECT. Это означает, что EXCEPT возвращает только строки, которые недоступны во втором операторе SELECT