- Автор Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Последнее изменение 2025-01-22 17:38.

Чтобы извлечь данные с помощью парсинга веб-страниц с помощью Python, вам необходимо выполнить следующие основные шаги:

- Найдите URL-адрес, который вы хотите очистить.

- Осмотр страницы.

- Найди данные вы хотите извлечь.

- Напишите код.

- Запустите код и извлеките данные .

- Хранить данные в нужном формате.

Учитывая это, что такое парсинг веб-страниц в Python?

Веб-парсинг с использованием Python . Веб-скрапинг это термин, используемый для описания использования программы или алгоритма для извлечения и обработки больших объемов данных из сеть . Независимо от того, являетесь ли вы специалистом по обработке данных, инженером или любым человеком, который анализирует большие объемы наборов данных, возможность царапать данные из сеть это полезный навык

Кроме того, может ли Excel извлекать данные с веб-сайта? Ты жестяная банка легко импортировать таблицу данные с веб-страницы в Excel , и регулярно обновляйте таблицу живыми данные . Откройте лист в Excel . От Данные в меню выберите либо Импортировать внешний Данные или получить внешний Данные . Введите URL принадлежащий страница в Интернете из которого вы хотите импортировать данные и щелкните "Перейти".

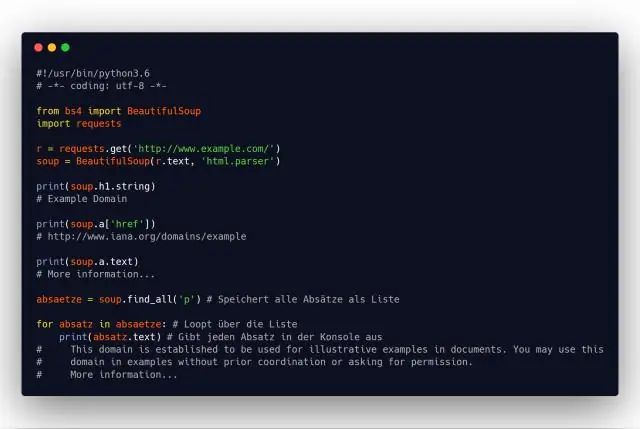

В связи с этим, как вы очищаете веб-сайт с помощью Python и BeautifulSoup?

Во-первых, нам нужно импортировать все библиотеки, которые мы собираемся использовать. Затем объявите переменную для URL-адреса страницы. Затем воспользуйтесь Python urllib2, чтобы получить HTML-страницу с объявленным URL-адресом. Наконец, проанализируйте страницу на BeautifulSoup формат, поэтому мы можем использовать BeautifulSoup работать над этим.

Законен ли сбор данных с веб-сайтов?

Часто, веб-сайты позволит третьему лицу соскабливание . Например, большинство веб-сайты дать Google явное или подразумеваемое разрешение на индексирование их сеть страниц. Несмотря на то что соскабливание повсеместно, непонятно законный . В отношении несанкционированных соскабливание , включая договор, авторское право и нарушение законов о движимом имуществе.

Рекомендуемые:

Как данные могут быть проверены при вводе в базу данных?

Проверка - это процесс, при котором данные, введенные в базу данных, проверяются, чтобы убедиться, что они разумны. Он не может проверить правильность введенных данных. Он может только проверить, имеют ли данные смысл. Валидация - это способ уменьшить количество ошибок в процессе ввода данных

Собирает ли Roomba пыль?

Пользователям нравится способность Roomba 650 эффективно очищать грязь и пыль с голых полов (твердых пород дерева, плитки и т. Д.). Он также очень эффективен при сборе шерсти домашних животных. И когда работа по уборке пылесосом завершена в течение дня, покупатели сообщают, что удобство сохраняется, поскольку мусорное ведро быстро и легко опорожняется

Какие протоколы используются в Интернете для передачи веб-страниц с веб-серверов?

Протокол передачи гипертекста (HTTP) используется веб-серверами и браузерами для передачи веб-страниц через Интернет

Что собирает сборщик мусора, делает Python?

Gc - Сборщик мусора. gc предоставляет базовый механизм управления памятью Python, автоматический сборщик мусора. Модуль включает в себя функции для управления работой сборщика и проверки объектов, известных системе, ожидающих сбора или застрявших в циклах обращения и не подлежащих освобождению

В чем разница между веб-хостингом на Linux и веб-хостингом на Windows?

Хостинг Linux совместим с PHP и MySQL, которые поддерживают такие сценарии, как WordPress, Zen Cart и phpBB. Хостинг Windows, с другой стороны, использует Windows в качестве операционной системы серверов и предлагает специальные технологии для Windows, такие как ASP ,. NET, Microsoft Access и Microsoft SQLserver (MSSQL)